Ollama

Ollama

Ollama 是一套可以讓你在自己的電腦上執行大型語言模型 (LLM, Large Language Model) 的開源軟體,就像是把 ChatGPT 裝在自己的電腦裡面這樣的感覺。

安裝

下載之後 Mac 版直接是一個應用程式,將它丟到應用程式檔案夾之後,使用滑鼠雙響就開始執行了。執行後會在螢幕上方的選單列中出現一個 Ollama 的小圖像表示已經執行了。不過畫面上不會有任何資訊、視窗或畫面出現,因為他是一套需要在終端機操作的軟體 (CLI, Command-line interface),是沒有任何圖形操作介面的。

先前啟動的軟體 (Ollama) 稱為 Ollama server。這套軟體採用的是 Client-server model 這樣的操作模式,真實的操控就需要使用終端機這一類的軟體了。

基本操作

使用終端機來進行操作。簡單介紹幾個常用指令,只要會這幾個,就可以開始玩了。

查看基本操作指令

ollama help

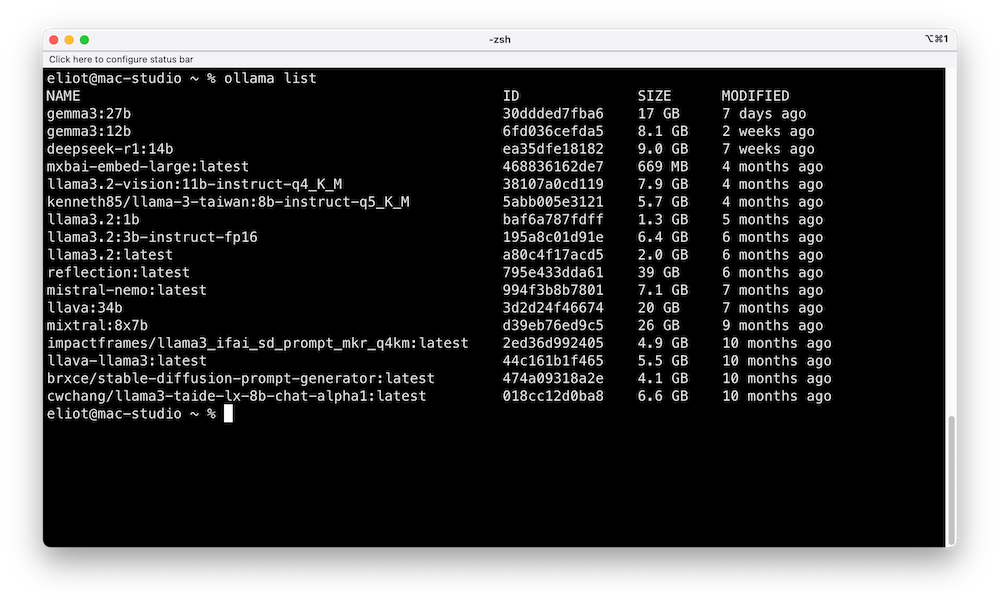

查看已經安裝了哪些模型

ollama list

電腦就會列出已經安裝模型的名稱 NAME、檔案大小 SIZE

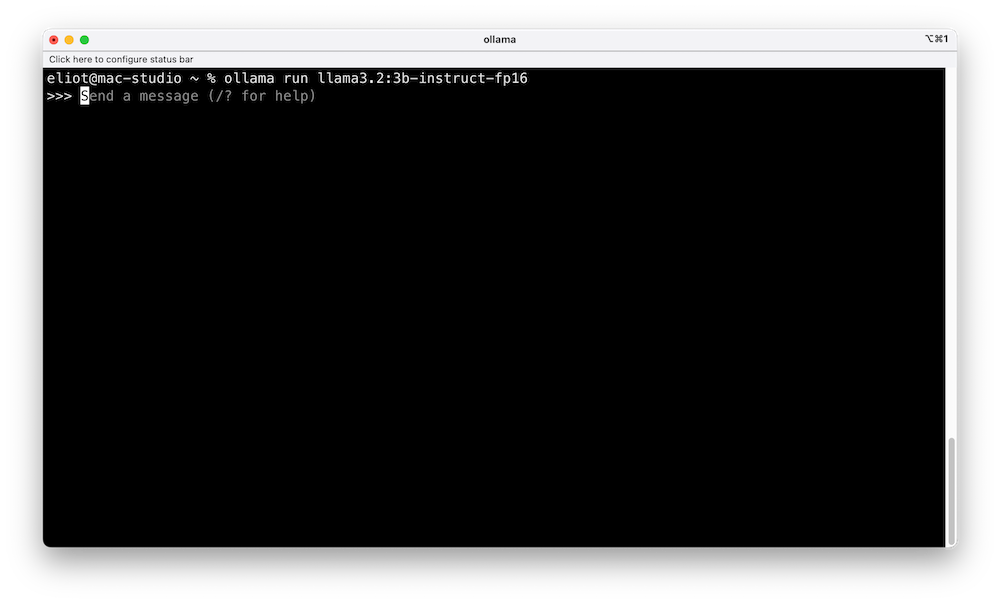

執行模型

從列出的清單當中,找到你想使用的模型名稱,例如 llama3.2:3b-instruct-fp16。就可以拷貝或是抄下來,到終端機中輸入

ollama run 模型全名

ollama run llama3.2:3b-instruct-fp16

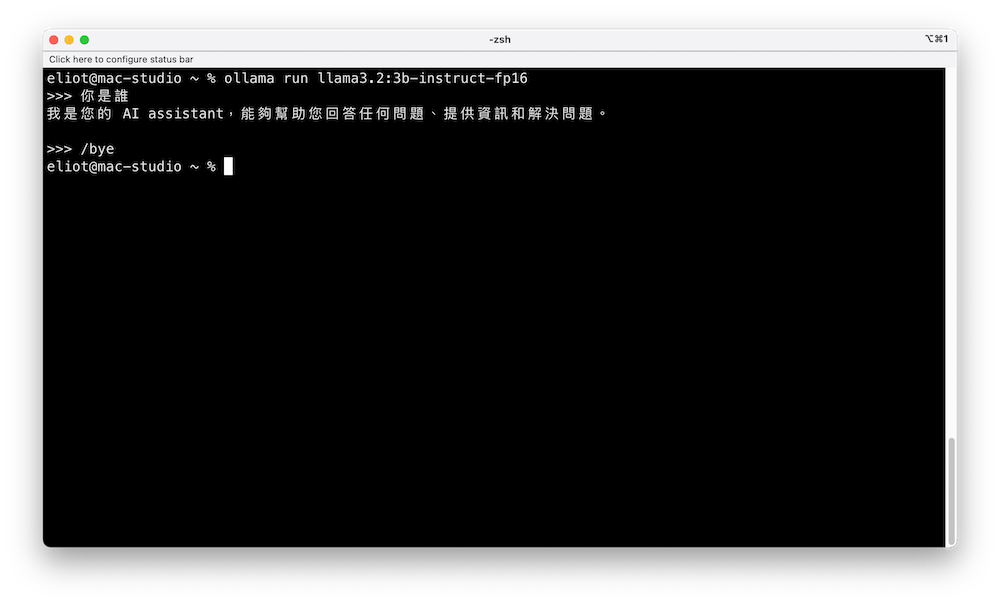

就可以開始問問題了。

結束模型

不想玩了,就輸入 /bye 即可。

想要使用圖形操作介面

如果想要使用圖形操作介面來進行操作的話,前面提到 Ollama 這套軟體的架構是 client - server,所以可以安裝其他客戶端 (Client)軟體進行操作。例如

- open-webui | GitHub

- Enchanted | GitHub | 可以在 iOS 生態系統(macOS、iOS、Watch、Vision Pro)中的所有裝置上提供未經過濾的、安全的、私密的和多模式的操作體驗。

- AnythingLLM | Site | GitHub

- macai | GitHub

修改 Ollama 預設模型存放位置

Ollama 模型預設的下載位置是 /Users/使用者/.ollama/models 。因為我們會下載、安裝很多模型下來玩,這些模型每一個都好幾 GB,如果你的系統硬碟容量沒有這麼大,可以考慮把模型存放的預設路徑改成其他的硬碟當中避免系統硬碟爆掉。

我會使用 ln 這個指令,把 ollama 內部預設的路徑,改成使用外接硬碟的路徑。像是這個樣子

ln -s /外接硬碟新路徑/models /軟體預設路徑/models

在終端機中輸入

rm -R ~/.ollama/models ## 把原來放模型的檔案夾清除

ln -s /Volumes/1M2/AI_models/ollama/models ~/.ollama/models

ln, link - link files, symbolic link

也可以使用另外一個指令,直接修改預設位置

lanuchctl setenv OLLAMA_MODELS /新路徑

Launchctl setenv OLLAMA_MODELS /Volumes/1M2/AI_models/ollama